Wil je om wat voor een reden dan ook af van de Experia Box, vervang deze dan door een eigen router. Dat is mogelijk, al kan het best een uitdaging zijn om een eigen router zo te configureren dat deze goed overweg kan met het iTV platform van KPN.

Wijzigingen in configuratie scripts voor EdgeRouters (22 juli 2022).

Edit (22 juli 2022): Wijziging van 21 juli 2022 teruggedraaid. De scripts voor te EdgeRouter X met vlan zijn bedoeld om op de corresponderende poort een switch aan te sluiten en niet een TV ontvanger.

Edit (21 juli 2022): Scripts voor EdgeRouter-X (SFP) aangepast zodat vlan 4 niet als vid maar als pvid op de eerste poort van de switch geactiveerd wordt.

Edit (12 maart 2022): Scripts voor EdgeRouter-X (SFP) aangepast zodat vlan 4 op de eerste poort van de switch geactiveerd wordt.

Edit (10 maart 2022): Scripts toegevoegd voor het gebruik van vlan 4 voor TV.

Edit (21 december 2021): Foutje in het script voor de EdgeRouter 4-SFP met TV ontvanger(s) op eth0 en eth1 hersteld

Edit (18 oktober 2021): Scripts toegevoegd voor de EdgeRouter 4 met TV ontvanger(s) op aparte poorten.

Edit (4 september 2021): Firewall inkomend toegevoegd op vlan 4 (IPTV). Overbodige global options op DHCP server verwijderd. Foutje in configuratie van IGMP proxy server in configuratiescripts voor EdgeRouters met SFP gecorrigeerd.

Edit (3 augustus 2021): Het configuratiescript voor de EdgeRouter Lite 3 is hernoemd naar de EdgeRouter 4.

Configuratiescripts toegevoegd voor de EdgeRouter 4 waarbij de SFP poort gebruikt wordt als WAN poort.

De configuratiescripts voor de EdgeRouter X SFP zijn nu voor gebruik van de SFP poort als WAN poort. Als de SFP poort niet gebruikt wordt dan kan het configuratiescript voor de EdgeRouter X gebruikt worden.

Kleine optimalisaties doorgevoerd in configuratiescripts voor de EdgeRouter X met TV ontvangers op aparte poorten.

Edit (1 augustus 2021): Configuratiescripts voor Telfort verwijderd en configuratiescript voor EdgeRouter X met 2 TV ontvangers toegevoegd.

Edit (22 februari 2021): De config.boot in het configuratiescript voor de EdgeRouter X KPN met telefonie via Experia Box bleek voor de Telfort variant van de EdgeRouter Lite 3 te zijn.

Edit (20 februari 2021): De config.boot bleek te missen in het Telfort script voor de EdgeRouter Lite 3 zonder telefonie via de Experia Box. Tevens bleek de verkeerde readme.txt opgenomen te zijn in de Telfort configuratiescripts voor de EdgeRouter Lite 3.

Edit (14 februari 2021): Kleine aanpassing zodat het plaatsen van de TV ontvangers op een eigen subnet iets eenvoudiger wordt.

Edit (15 januari 2021): Het lijkt er op, als de technische migratie gestart wordt, dat ex Telfort abonnees hun Experia Box tijdelijk zullen moeten aansluiten om overgezet te kunnen worden van de Telfort architectuur naar de KPN architectuur. Daarna kan je direct de eigen router weer gebruiken mits de configuratie daarvan ook omgezet is van Telfort naar KPN.

Edit (14 januari 2021): Foutje gecorrigeerd in de configuratiescripts voor de EdgeRouter X met TV op eth1.

Edit (19 december 2020): KPN heeft op 14 december een nieuwe dienst geïntroduceerd zijnde een malwarefilter. Feitelijk is dit niets anders dan het gebruik van andere DNS servers.

De anti-malware DNS servers van KPN hebben de onderstaande IP adressen:

- 195.121.97.202

- 195.121.97.203

- 2a02:a47f:ac::210

- 2a02:a47f:ac::212

Wil je gebruik maken van deze dienst dan zal je de DNS servers moeten overnemen.

Edit (27 november 2020): Ik heb de configuratiescripts voor Telfort met telefonie via de Experia Box aangepast.

Edit (21 november 2020): Ik heb een foutje in de bootstrap hersteld die er voor zou moeten zorgen dat na een reboot van de EdgeRouter de IGMP proxy server wel automatisch opgestart gaat worden. Ik raad bestaande gebruikers, die hun EdgeRouter met een configuratiescript van voor 21 november 2020 geconfigureerd hebben, aan de fix (EdgeRouter-KPN-Bootstrap-Fix (zip 21 november 10:13) te downloaden en de wijzigingen op hun router door te voeren.

Edit (7 november 2020): Ik heb de configuratiescripts voor onze Telfort broeders toegevoegd.

Edit (6 november 2020): Ik heb in de configuratiescripts de bootstrap voor de EdgeRouter aangepast zodat standaard geconfigureerd wordt dat de IGMP proxy server pas gestart wordt nadat het netwerk geactiveerd is. Hierdoor is een herstart van de IGMP proxy server na een reboot niet meer nodig. Bestaande EdgeRouter gebruikers kunnen het script EdgeRouter-KPN-Bootstrap-Fix (zip 6 november 17:40) downloaden om de wijzigingen op hun router door te voeren.

Edit (25 maart 2020): De vrije (modem)routerkeuze is vanaf vandaag een feit. 😀 Daarmee is het nu ook mogelijk een eigen router te gebruiken als je vaste telefonie bij KPN hebt ondergebracht.Als je een EdgeRouter gaat gebruiken met een eigen VoIP ATA voor telefonie dan kan je kiezen voor de configuratiescripts zonder telefonie. Zet hierbij wel de SIP functionaliteit uit op de EdgeRouter.

Edit (4 september 2019): Sinds 12 augustus is dit ook voor VDSL abonnees -zonder vaste telefoon abonnement van KPN- mogelijk nu in OS 7.13 van de Fritz!Box routers een configuratie wizard voor de KPN netwerken is opgenomen. Overigens is de Fritz!Box met OS 7.13 ook inzetbaar op glasvezelaansluitingen. Gebruik de Fritz!Box vergelijker om een voor jouw aansluiting geschikt model te selecteren. Laat je hierbij overigens niet misleiden door de filter "glasvezel". Het lijkt er dan op dat alleen de 5490 geschikt zou zijn maar dat is niet zo. Elke Fritz!Box met een WAN poort kan op de NTU aangesloten worden. Let er ook goed op dat OS 7.13 of nieuwer beschikbaar is op die Fritz!Box.

Met dit topic hoop ik dat wij als abonnees van KPN elkaar kunnen helpen met het configureren van een eigen router.

LET OP: Het onderstaande zal waarschijnlijk al snel een vrij hoog technisch gehalte gaan krijgen waardoor het voor velen best lastig te volgen zou kunnen zijn. Toch hoop ik dat uiteindelijk in dit topic goede en begrijpelijke handleidingen zullen ontstaan waardoor ook de minder technisch aangelegde abonnee in staat zal zijn zijn/haar eigen router te gebruiken. Mocht je denken ... dit gaat me toch echt mijn pet te boven ... dan is wellicht het volgende topic iets voor jou: Gebruik een eigen router achter de Experia Box.

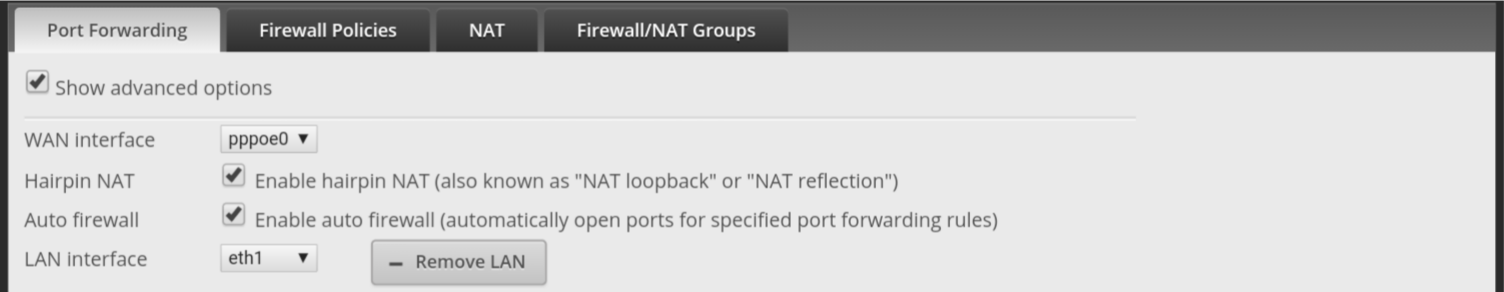

Wees je er overigens terdege van bewust dat lang niet elke router geschikt is om de Experia Box te vervangen. Met name de configuratie van het IPTV gedeelte kan nog wel eens een spelbreker blijken te zijn. Zo zie je bijvoorbeeld op TP-Link en Asus routers functionaliteit voor het inrichten van IPTV maar dat is bridged-IPTV waarbij een LAN poort van de router gebridged wordt op het IPTV vlan van KPN (vlan 4). KPN maakt echter gebruik van routed-IPTV waarbij de TV ontvangers, net als alle andere apparatuur, gewoon met Internet (vlan 6) verbonden worden en een IGMP proxy server op de router er voor zorgt dat de TV streams van vlan 4 betrokken worden. Gelukkig zijn er ook routers te vinden waarmee de Experia Box wel succesvol vervangen kan worden maar het is wel cruciaal dat je bij de aanschaf van een router goed kijkt of deze geschikt is voor routed IPTV van KPN.

Bron.

Onderaan dit topic staat een lijst met routers die tot op heden succesvol op een KPN aansluiting met IPTV in gebruik genomen zijn.

KPN zal je geen support meer kunnen bieden bij eventuele storingen en dus ben je dan op jezelf aangewezen om zo'n storing te verhelpen. Daarnaast zullen de KPN servicetools niet meer werken.

Zelf heb ik een Ubiquiti EdgeRouter 4 ingezet om de Experia Box te vervangen. Deze router heeft geen ingebouwde wifi, maar daarvoor gebruik ik losse WiFi accesspoints zoals de EDIMAX CAP1200, de KPN WiFi "versterker", de Experia WiFi of bijvoorbeeld de Ubiquiti Unifi AP AC PRO.

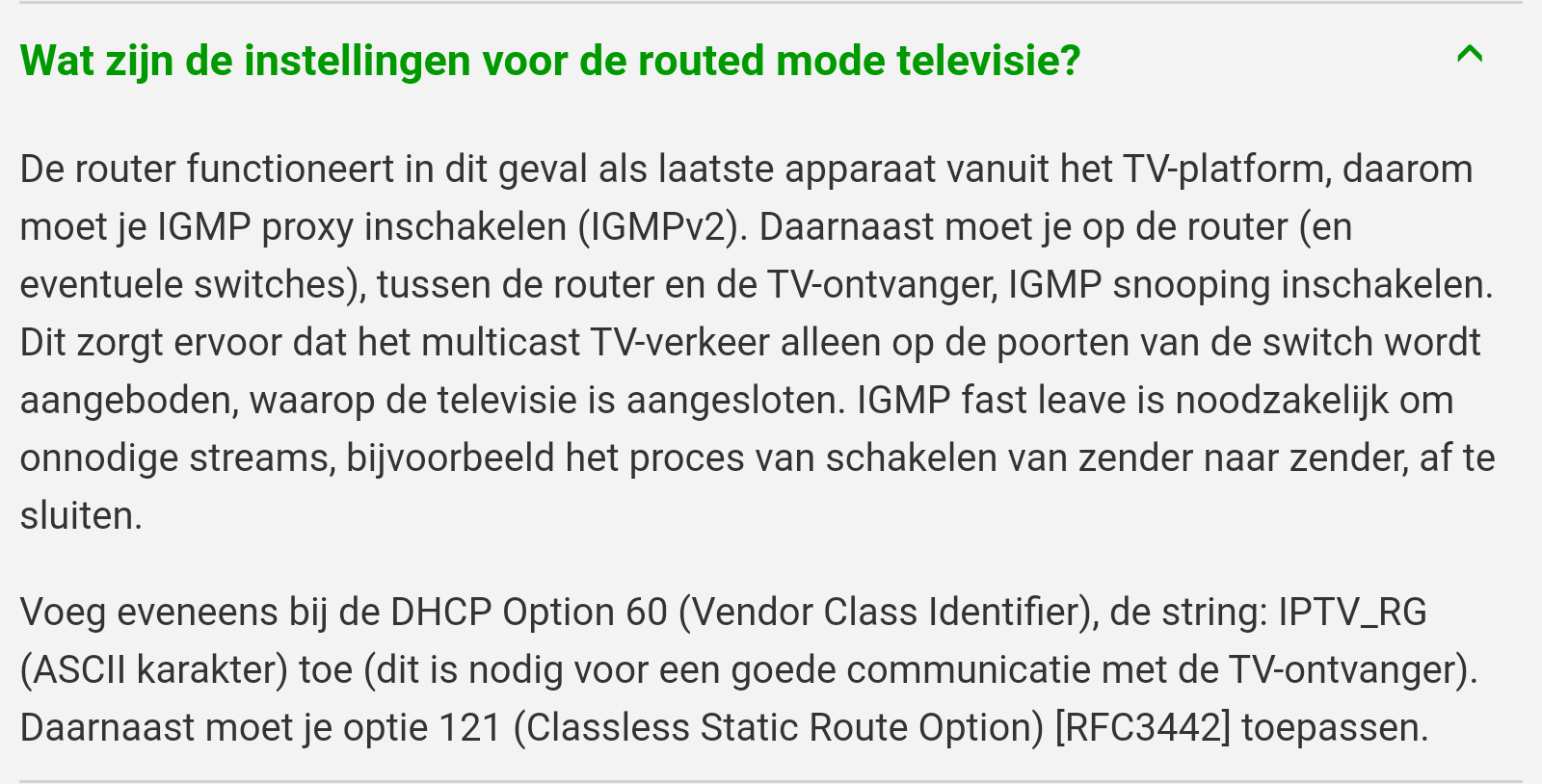

Onderstaand een screenshot van het dashboard van mijn EdgeRouter 4 waarin zichtbaar is dat deze een (pppoe) verbinding opgebouwd heeft met het KPN netwerk op vlan 6 en dat het IPTV op vlan 4 operationeel is.

Ik hoop dat voor een aantal geschikte routers configuratie scripts geschreven gaan worden die we dan hier op kunnen nemen.

Configuratie scripts (downloads)

Let op: De onderstaande scripts zetten de login en wachtwoord op de standaard die Ubiquiti zelf ook gebruikt (ubnt). Men doet er zeer verstandig deze na de configuratie te wijzigen.

EdgeRouter 4

Met telefonie via Experia Box (zip 4 september 2021 16:45).

Zonder telefonie via Experia Box (zip 18 oktober 2021 15:17).

Als je de TV ontvanger(s) op een apart vlan wilt plaatsen dan kan je één van de onderstaande scripts gebruiken.

Met telefonie via Experia Box en TV via vlan 4 (zip 10 maart 2022 13:47).

Zonder telefonie via Experia Box en TV via vlan 4 (zip 10 maart 2022 13:47).

Als je één TV ontvanger gebruikt en deze rechtstreeks op de EdgeRouter aan kunt sluiten, gebruik dan het onderstaande script.

Zonder telefonie via Experia Box en eth1 voor TV ontvanger (zip 18 oktober 2021 15:17).

De configuratiescripts voor de EdgeRouter 4 zijn ook geschikt voor de EdgeRouter Lite 3 en EdgeRouter 6P. De SFP poort alsmede eth3 en hoger worden in deze scripts niet geconfigureerd, dat kan dan eventueel achteraf handmatig gedaan worden.

EdgeRouter 4 - SFP

De onderstaande scripts zijn specifiek voor het gebruik van de SFP poort als WAN poort.

Met telefonie via Experia Box (zip 4 september 2021 18:04).

Zonder telefonie via Experia Box (zip 4 september 2021 18:04).

Als je de TV ontvanger(s) op een apart vlan wilt plaatsen dan kan je één van de onderstaande scripts gebruiken.

Met telefonie via Experia Box en TV via vlan 4 (zip 10 maart 2022 13:47).

Zonder telefonie via Experia Box en TV via vlan 4 (zip 10 maart 2022 13:47).

Als je één TV ontvanger gebruikt en deze rechtstreeks op de EdgeRouter aan kunt sluiten, gebruik dan het onderstaande script.

Zonder telefonie via Experia Box en eth1 voor TV ontvanger (zip 18 oktober 2021 15:17).

Als je twee TV ontvangers gebruikt en deze rechtstreeks op de EdgeRouter aan kunt sluiten, gebruik dan het onderstaande script.

Zonder telefonie via Experia Box en eth0/1 voor TV ontvangers (zip 21 december 2021 17:22).

De SFP poort zal voorzien moeten zijn van een RJ45 module voor aansluiting op de NTU, ONT of VDSL modem danwel een Fiber module voor een rechtstreekse aansluiting op de FTU.

Let op: De EdgeRouter kan niet rechtstreeks op de FTU aangesloten worden bij XGS-PON aansluitingen.

EdgeRouter X

Met telefonie via Experia Box (zip 4 september 2021 16:45).

Zonder telefonie via Experia Box (zip 4 september 2021 16:45).

Als je de TV ontvanger(s) op een apart vlan wilt plaatsen dan kan je één van de onderstaande scripts gebruiken.

Met telefonie via Experia Box en TV via vlan 4 op eth2 (zip 22 juli 2022 11:55).

Zonder telefonie via Experia Box en TV via vlan 4 op eth1 (zip 22 juli 2022 11:55).

Als je één TV ontvanger gebruikt en deze rechtstreeks op de EdgeRouter aan kunt sluiten, gebruik dan de onderstaande scripts.

Met telefonie via Experia Box en eth1 voor TV ontvanger (zip 4 september 2021 16:45).

Zonder telefonie via Experia Box en eth1 voor TV ontvanger (zip 4 september 2021 16:45).

Als je twee TV ontvangers gebruikt en deze rechtstreeks op de EdgeRouter aan kunt sluiten, gebruik dan het onderstaande script.

Zonder telefonie via Experia Box en eth1/2 voor TV ontvangers (zip 4 september 2021 16:45).

De configuratiescripts voor de EdgeRouter X werken ook voor de EdgeRouter 10X, 12 en 12P waarbij eth3 en hoger achteraf handmatig geconfigureerd moeten worden.

EdgeRouter X - SFP

De onderstaande scripts zijn specifiek voor het gebruik van de SFP poort als WAN poort.

Met telefonie via Experia Box (zip 4 september 2021 18:06).

Zonder telefonie via Experia Box (zip 4 september 2021 18:06).

Als je de TV ontvanger(s) op een apart vlan wilt plaatsen dan kan je één van de onderstaande scripts gebruiken.

Met telefonie via Experia Box en TV via vlan 4 op eth1 (zip 22 juli 2022 11:55).

Zonder telefonie via Experia Box en TV via vlan 4 op eth0 (zip 22 juli 2022 11:55).

De SFP poort zal dan dus voorzien moeten zijn van een RJ45 module voor aansluiting op de NTU, ONT of VDSL modem danwel een Fiber module voor een rechtstreekse aansluiting op de FTU.

Let op: De EdgeRouter kan niet rechtstreeks op de FTU aangesloten worden bij XGS-PON aansluitingen.

Heb je vaste telefonie van KPN en wil je jouw Experia Box blijven gebruiken voor telefonie, kies dan voor een configuratiescript "met telefonie via Experia Box". Let op, de V12 is hier niet voor geschikt.

Heb je vaste telefonie van KPN en laat je die via een eigen VoIP ATA lopen, kies dan voor een configuratiescript "zonder telefonie via Experia Box".

Het wachtwoord voor jouw SIP account van je via de SIP service tool instellen.

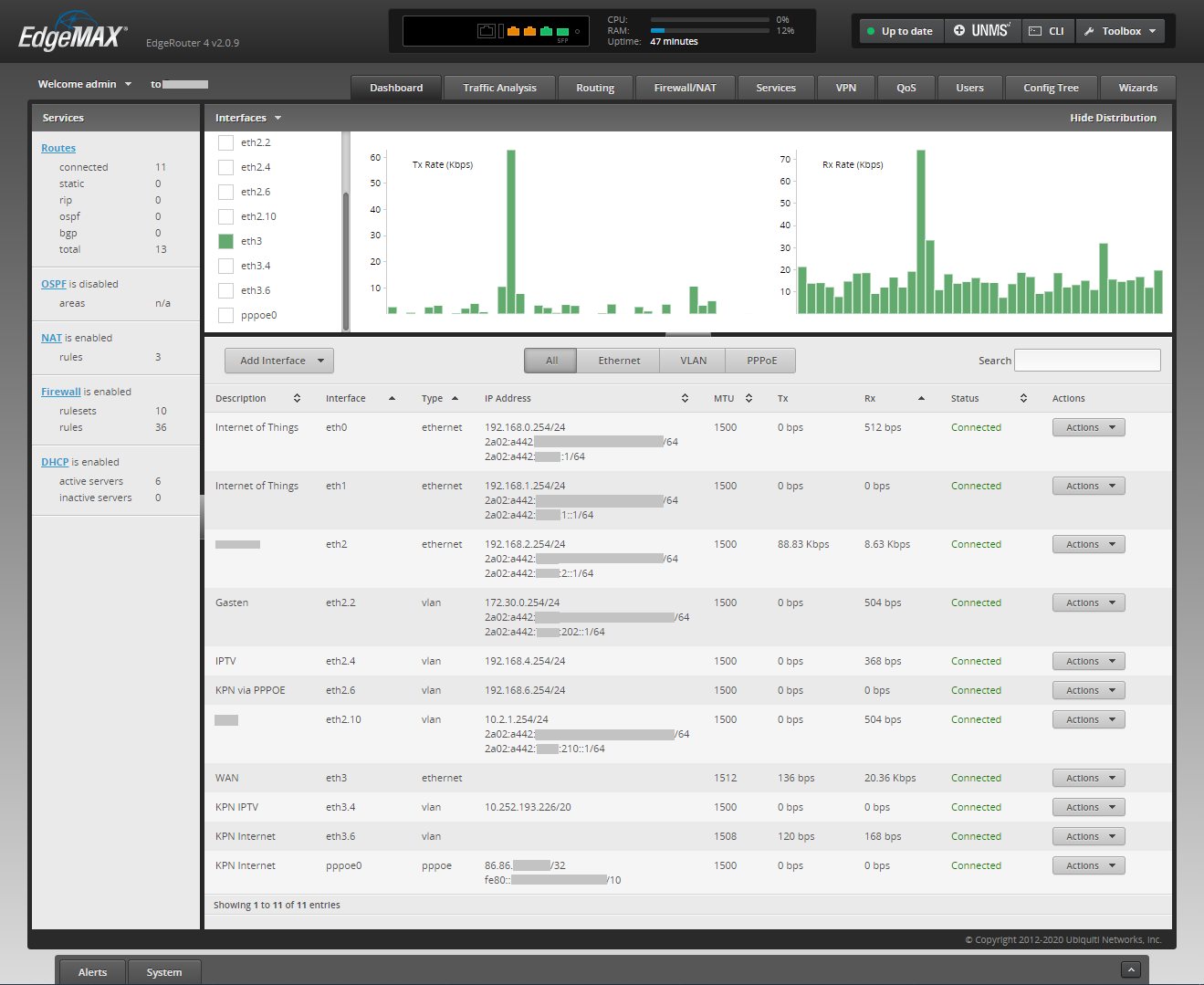

Zorg er dan tevens voor dat de SIP module op de EdgeRouter gedisabled is.

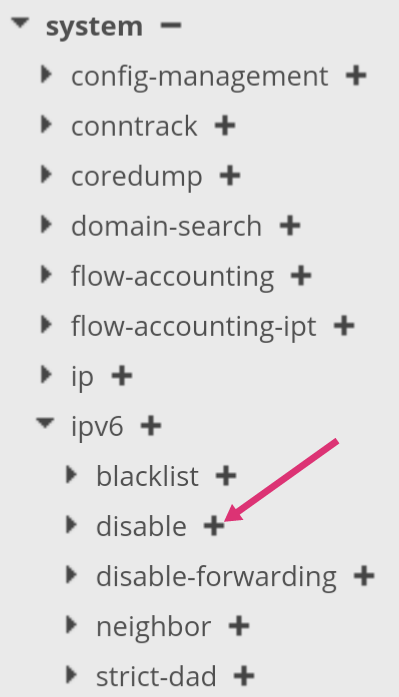

De bovenstaande configuraties zetten IPv6 op de EdgeRouter aan. Mocht het zijn dat op jouw aansluiting IPv6 nog niet volledig operationeel is, dan kan je op de EdgeRouter IPv6 eenvoudig uitzetten (disablen) via de Config Tree -> System -> ipv6.

Druk daartoe op het plusteken naast disable en vervolgens op Preview en Apply.

Let op: Het uit (of aan) zetten van IPv6 vereist wel dat de EdgeRouter gereboot wordt.

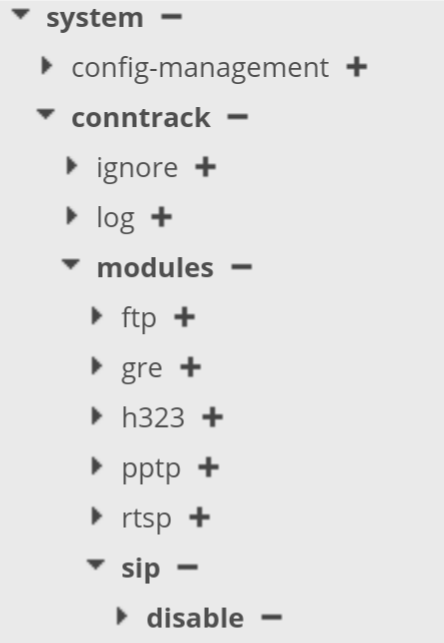

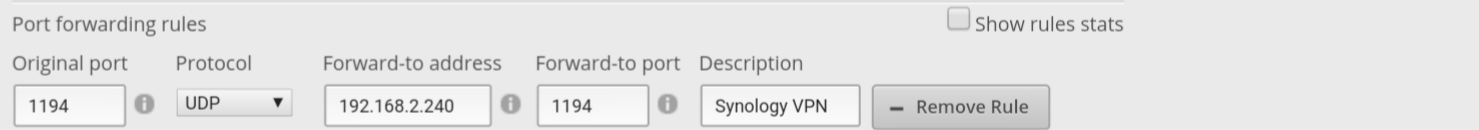

Heb je services draaien die je vanaf Internet moet kunnen benaderen, configureer dan de port-forwarding als onderstaand...

...en voeg daarna de benodigde poorten toe met de verwijzing naar het LAN IP adres van het apparaat dat die service levert.

In het onderstaande voorbeeld forward ik OpenVPN naar mijn Synology NAS.

Ubiquiti UniFi Security Gateway: Zie https://www.vanachterberg.org/usg-kpn-ftth/posts/unifi-security-gateway-kpn-ftth-iptv-ipv6/

UniFi Dream Machine (Pro): Zie https://github.com/fabianishere/udm-iptv

Unifi Gateway Lite: Zie dit bericht.

OPNsense & pfSense: Zie https://gathering.tweakers.net/forum/list_message/67694326#67694326

DrayTek Vigor: Zie dit bericht.

De DrayTek Vigor brengt het gebruik van een eigen router binnen bereik van de VDSL abonnee en dat is een zeer grote stap voorwaarts, waarvoor dank aan

Synology RT1900ac / RT2600ac / RT6600ax / MR2200ac / WRX560: Zie dit topic

TP-Link ER605 v2.0: Zie dit topic.

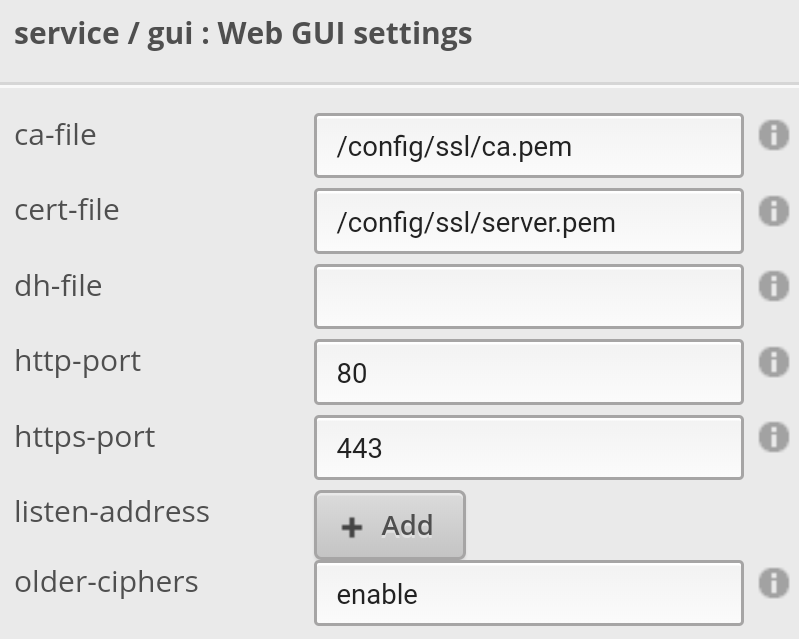

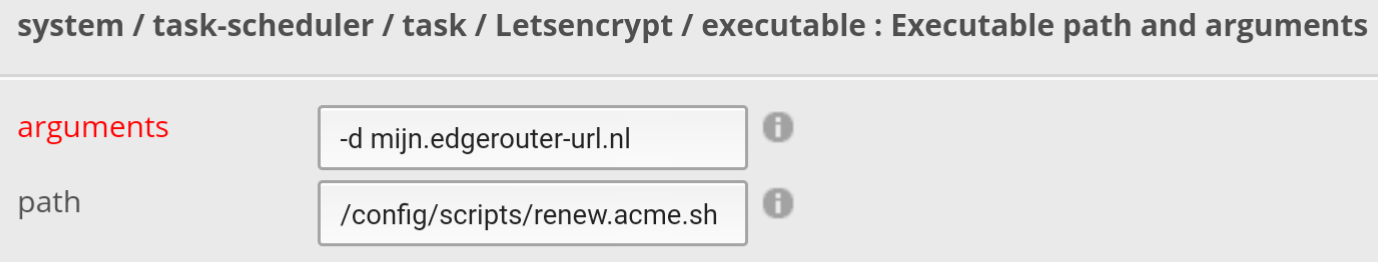

Ik heb mijn EdgeRouter 4 voorzien van een Let's Encrypt SSL certificaat waardoor ik een https verbinding kan opzetten en de uitwisseling van informatie dus encrypted is.

Hiervoor heb ik de github van j-c-m gebruikt en een taak in de task-scheduler geplaatst die om de 14 dagen opgestart wordt om het SSL certificaat te vernieuwen mocht dit nodig zijn.

Je hebt wel een url nodig die naar jouw publieke IP adres wijst.

Lijst met (modem)routers die succesvol op een KPN aansluiting i.c.m. IPTV in gebruik genomen zijn.

- EdgeRouter (verschillende typen)

- UniFi Dream Machine (Pro) / Unifi Dream Router

- Unifi Gateway Lite

- FRITZ!Box voorzien van FRITZ!OS 7.13 of hoger

- Draytek Vigor 2760n, 2865 en 3910 en vast en zeker ook andere (nieuwere) modellen

- Synology RT1900ac / RT2600ac / RT6600ax / MR2200ac / WRX560

- TP-Link AX10 hardware versie 1.0. Andere modellen uit de AX serie zouden ook geschikt moeten zijn maar helaas worden er veel problemen gemeld.

- TP-Link ER605 v2.0

- Routers/PC's op basis van RouterOS van Mikrotik

- Routers/PC's op basis van OPNsense of pfSense

Lijst met modems die op een KPN aansluiting gebruikt kunnen worden.

- Draytek Vigor 130 of 165/167 in full-bridge-mode. Let op: De Vigor 130 en 165/167 ondersteunen (nog) geen bonding. De Vigor 165 en 167 ondersteunen wel VPlus.

- Zyxel VMG4005-B50A. Dit modem ondersteunt zowel bonding als VPlus.

-

ZTE H186 DSL NT. Ook dit modem ondersteunt zowel bonding als Vplus.

Ik hoop dat deze lijst steeds langer zal gaan worden, maar staat jouw (modem)router er niet tussen Google dan eerst of er al iemand is die dat apparaat succesvol in gebruik genomen heeft.